5.1 Begrüßung und aktueller Stand der AI-Technologie

Guten Tag, meine Damen und Herren! Leider ist das Touchpanel hier im Hörsaal defekt, weswegen zwar die Projektion funktioniert, nicht aber die Mikrofone. Ich werde versuchen, laut genug zu sprechen, damit Sie mich alle gut verstehen können. Sollte das nicht der Fall sein, geben Sie mir bitte ein Zeichen.

Die Entwicklung im Bereich der Künstlichen Intelligenz schreitet in rasantem Tempo voran. Gefühlt werden jede Woche neue, leistungsfähigere Modelle vorgestellt, die immer größere Versprechungen machen. Es entsteht fast der Eindruck, als seien bereits heute oder zumindest morgen alle Probleme gelöst. Die großen Computer-Technologie-Konzerne überbieten sich gegenseitig mit neuen AI-Modellen, deren Leistungsfähigkeit anhand verschiedener Skalen bewertet wird.

Doch bei genauerer Betrachtung zeigt sich, dass diese Bewertungsmaßstäbe derzeit noch recht rudimentär sind. Die Modelle mögen zwar in den Tests gut abschneiden, erfüllen aber bei weitem noch nicht alle Anforderungen, die wir an eine wirklich intelligente AI stellen würden. Genau darum soll es heute gehen: Was erwarten wir eigentlich von einer KI? Ich möchte mit Ihnen ein eigenes Modell und ein Projekt skizzieren, an dem Sie auch gerne mitwirken können.

5.2 Generative AI und AI-Characters

In der letzten Vorlesung haben wir AI-Modelle als generative AI kennengelernt. Das bedeutet, dass sie aus einem Input, beispielsweise einem Text oder einer Interaktion über Audio oder Video, einen Output generieren. Dieser generierte Output ist das eigentliche Leistungsergebnis dieser Modelle.

Ein spannender Aspekt dabei ist, dass wir die Art und Weise des Reagierens der Modelle mitgestalten können, indem wir sogenannte AI-Characters definieren. Damit lässt sich beispielsweise festlegen, in welcher Sprache eine Antwort gegeben werden soll. Die sprachlichen Fähigkeiten der Modelle sind mittlerweile so beeindruckend, dass sie für Muttersprachler nahezu fehlerfreie Texte produzieren können.

5.2.1 Übersetzungsleistung als Beispiel für semantisches Verständnis

Ein herausragendes Beispiel für die Leistungsfähigkeit der generativen Modelle ist ihre Fähigkeit zur Übersetzung. Sie geben nicht einfach nur irgendwelche Texte aus, sondern bedeutungsgehaltvollen Content. Bei einer Übersetzung wird der Inhalt in einer anderen Sprache neu formuliert, ohne dass dieser Text zuvor so publiziert wurde. Dennoch hat er die gleiche Bedeutung wie der Ursprungstext.

Diese semantische Kompetenz ist der Kern dessen, was die aktuelle Generation von AI-Modellen so besonders macht. Ein AI-Character ist also gewissermaßen eine Individualität, ein besonderes Reaktionsvermögen eines Modells.

5.3 Herausforderungen und Erwartungen an zukünftige AI-Modelle

Doch lassen Sie uns nun die Perspektive wechseln. Anstatt nur das zu betrachten, was uns als “Künstliche Intelligenz” präsentiert wird, sollten wir uns überlegen: Was erwarten wir eigentlich von einer KI, die vielleicht erst noch entwickelt werden muss?

Bei genauerem Hinsehen werden wir feststellen, dass die aktuellen Modelle diese Anforderungen bei Weitem noch nicht erfüllen. In den beeindruckenden Präsentationen der Tech-Firmen werden bestimmte Leistungen, wie etwa die Simultanübersetzung, hervorgehoben. Doch viele wichtige Aspekte, die wir von einer wirklich intelligenten AI erwarten würden, bleiben dabei unerwähnt.

5.3.1 Halluzination als Defizit aktueller Modelle

Einer der am häufigsten diskutierten Kritikpunkte ist das Phänomen der Halluzination. Die KI-Modelle können zwar wunderbar formulieren, aber den Wahrheitsgehalt ihrer Aussagen nicht validieren oder gar begründen. Auch der Begriff des “Wissens” wird in diesem Zusammenhang oft sehr leichtfertig verwendet, ohne zu reflektieren, was es eigentlich bedeutet, über Wissen zu verfügen.

Es ist wichtig zu verstehen, dass Information nicht gleichbedeutend mit Wissen ist. Informationen sind mathematisch definiert und messbar, haben aber nichts mit Wissen im eigentlichen Sinne zu tun. Wenn also Firmen davon sprechen, “Wissensnetzwerke” zu erstellen, ist das eher als Propaganda zu verstehen denn als tatsächliche Abbildung von Wissen.

5.4 Kompetenzbereiche aktueller und zukünftiger AI-Modelle

Dessen ungeachtet verfügen die aktuellen Modelle durchaus über beeindruckende Fähigkeiten. Die sogenannten Large Language Models (LLM) können als Reaktion auf einen Input, der aus Texten, Bildern oder anderen symbolhaften Inhalten bestehen kann, inhaltlich korrespondierende Outputs generieren.

5.4.1 Sprachkompetenz als Basis

Eine der grundlegendsten Kompetenzen der LLMs ist die Verarbeitung natürlicher Sprache. Sie verfügen über eine erstaunliche Sprachkompetenz, die sie durch das Training anhand von Milliarden von Beispielen erworben haben. Dabei lernen sie nicht nur die grammatischen Regeln, sondern auch den inhaltlichen Zusammenhang.

Genau hier liegt aber auch die Ursache für das Problem der Halluzination: Da die Modelle mit so vielen Beispielen trainiert wurden, finden sie für fast jede Fragestellung eine passende und plausibel klingende Formulierung - unabhängig davon, ob der Inhalt tatsächlich wahr oder zutreffend ist.

5.4.2 Erweiterbarkeit durch Kontextinformationen

Die sprachliche Basis der LLMs lässt sich durch Zusatzinformationen, den sogenannten Kontext, erweitern und anreichern. Dadurch können die Modelle an spezifische Aufgabenstellungen angepasst werden. Der Kontext umfasst alle Zusatztextinformationen, die zusätzlich zum eigentlichen Input bereitgestellt werden, um einen gewünschten Output zu generieren.

5.4.3 Bedeutung von Handlungsanweisungen

Für die Interaktion mit LLMs ist es wichtig zu verstehen, wie Handlungsanweisungen, also Instruktionen zur Ausführung einer bestimmten Aufgabe, formuliert werden müssen. Da die Modelle mit natürlicher Sprache arbeiten, müssen diese Anweisungen so formuliert sein, dass sie eindeutig und unmissverständlich sind.

Die philosophische Handlungstheorie hat sich eingehend damit beschäftigt, welche Aspekte eine vollständige Handlungsanweisung beinhalten muss:

- Eine Absicht oder ein Ziel, das erreicht werden soll

- Eine Beschreibung der auszuführenden Handlung(en)

- Die notwendigen Mittel oder Ressourcen zur Ausführung

Nur wenn all diese Aspekte klar definiert sind, kann eine Handlungsanweisung von einem KI-System sinnvoll ausgeführt werden.## Grundlagen der Handlungstheorie

In der philosophischen Literatur gibt es das sogenannte “Belief-Desire-Modell” einer Handlung. Dieses Modell besagt, dass für die Ausführung einer Handlung zwei Elemente vorliegen müssen: Eine Zielvorstellung, die erreicht werden soll (Desire), und eine Überzeugung über die vorliegenden Situationsgegebenheiten (Belief). Diese beiden Elemente sind logisch gesehen völlig unterschiedlich.

Die Handlungstheorie hat sich eingehend mit den komplexen Belief-Desire-Netzwerken befasst, und zwar nicht nur für Individuen, sondern auch für große Kollektive. Derzeit werden diese komplexen Netzwerke von keinem der AI-Modelle auch nur im Ansatz realisiert. Hier sieht man, welches Entwicklungspotenzial noch in der AI-Technologie steckt.

5.5 Instruktionsausführung in der AI

Alle aktuellen AI-Modelle führen im Wesentlichen Instruktionen aus. Diese Instruktionen werden in natürlicher Sprache durch Handlungsanweisungen ausgedrückt. Sie beschreiben, welche Handlung unter welchen Zielen und mit welchen Mitteln ausgeführt werden soll. Dieses Prinzip lässt sich bis hin zur Analyse wissenschaftlicher Texte nachvollziehen. In der Wissenschaftskommunikation werden in Publikationen sehr konkrete Ausführungen wissenschaftlicher Handlungsoperationen publiziert, kommuniziert, aufgenommen und von anderen Rezipienten weitergesponnen.

In der AI-Entwicklung verschiebt sich der Fokus mittlerweile von den ursprünglichen Chat-Ideen, bei denen das Mensch-Maschine-Interface durch eine dialogische Gesprächssituation kanalisiert wurde, hin zu einer zwar ebenfalls dialogisch geführten Interaktion, bei der es aber im Kern um Instruktionen und Handlungsanweisungen geht.

5.6 Lernen von Kompetenz in der AI

Hinter all diesen AI-Systemen steht das Lernen von Kompetenz, auch wenn wir das bei der Nutzung kaum wahrnehmen. Man könnte glauben, dass die aktuellen AI-Modelle bereits eine vollständige Kompetenz mitbringen und diese nur noch anwenden und dem Nutzer zur Verfügung stellen. Das ist jedoch nicht der Fall.

Wie bereits erwähnt, ist das Chatten, also das dialogische Klären von Themen und Instruktionen, bereits ein interaktiver Vorgang. Ihre Reaktionen, Korrekturen und Rückmeldungen in einem Chat tragen wesentlich dazu bei, einen geeigneten Kontext zu konstruieren. Dieser Kontext ist wichtig, um die entsprechende zielführende Instruktion dorthin zu führen, wo ein Endergebnis für Sie einen Wert hat und Ihren Erwartungen entspricht.

Die AI-Modelle leben und interagieren davon, dass Sie als Nutzer Interaktionen und Informationen einbringen, die in den jeweiligen Funktions- und Kompetenzbereich des Modells mit einfließen. Im Hintergrund ist all dies in den Modellen implementiert, sodass sie aus Ihren Reaktionen und denen vieler anderer Nutzer ständig lernen können. Die rapide Abfolge der Versionserneuerungen dieser Modelle ist nicht nur Ausdruck der technischen Weiterentwicklung, sondern auch der Tatsache, dass die massiv millionenfache Interaktion mit diesen Modellen zu einer stetigen Verbesserung führt.

5.6.1 Beispiel: Leonhard Euler

Ich habe dies selbst am Beispiel der biografischen Informationen zum Mathematiker Leonhard Euler getestet, der zweimal verheiratet war. Historisch ist es gar nicht so einfach herauszufinden, wer seine zweite Ehefrau war. Am Anfang gaben die AI-Modelle im Netz auf die Frage nach dem Namen von Eulers zweiter Frau die skurrilsten Antworten - völlig absurde Halluzinationen. Nachdem ich die Anfrage jedoch zehnmal beim gleichen Modell am selben Tag gestellt hatte, wusste das Modell abends die richtige Antwort. Sobald Sie dem System mitteilen, dass eine Antwort falsch ist und korrigiert werden muss, sind die Modelle so aufgebaut, dass sie diese Korrektur mit aufzeichnen.

Mit Ihrer Zustimmung zur Nutzerdatennutzung und Ihren Reaktionen sind Sie also Teil des weltweiten Teams zur Optimierung und Informationsverbesserung dieser Modelle. Das ist derzeit nicht abschaltbar. Das Lernen von Kompetenzen gehört mit dazu, auch wenn es sich derzeit auf eine Kleinstlernkompetenz beschränkt, die sich im Wesentlichen auf die Aufbereitung der Nutzerreaktionen reduziert.

5.6.2 Weitere Lernmöglichkeiten

Die Lernmöglichkeiten gehen jedoch noch viel weiter. Die Hersteller der Modelle bieten Ihnen beispielsweise an, Ihre ausgewählten PDFs hochzuladen, um die darin enthaltenen Informationen für die Beantwortung Ihrer Anfragen nutzbar zu machen. Das bringt Ihnen zwar einen Vorteil, aber die von Ihnen ausgewählten PDFs dienen den Firmen zugleich als Qualitätsindizes. Sie erkennen daran, welche Informationen für die zukünftige Verbesserung der Modelle relevant sind, sodass diese auch bei allen anderen Anfragen berücksichtigt werden können. Die von Ihnen bereitgestellten Informationen fließen also permanent in das Modelltraining ein, einschließlich des Wissenshintergrunds.

5.6.3 Digitalisierung historischer Bestände

Nicht umsonst hatte Google vor 25 Jahren Verträge mit den großen Bibliotheken der Welt abgeschlossen, um historische, urheberrechtsfreie Bestände zu digitalisieren. Lange fragte man sich, warum Google diesen Millionenaufwand betreibt. Heute sehen wir den enormen Wert dieser digitalisierten Bestände. Sie dienen als Informationshintergrund und Wissensquelle für die Aufbereitung der MLM-Modelle. Die Verarbeitung unseres in den Bibliotheken enthaltenen Kulturwissens hat jedoch noch kaum begonnen. Die digitalisierten Bestände sind zunächst nur eine Art Referenz. Die eigentliche inhaltliche Aufbereitung dieser Bestände wird in den nächsten Jahren mit Sicherheit erfolgen.

5.7 Generierung und Kontext in der Interaktion mit Chatmodellen

In der letzten Stunde haben wir anhand einiger Beispiele diskutiert, wie die Interaktion mit einem Chatmodell aussieht. An einem Modell habe ich Ihnen gezeigt, wie die Frage “Wer war Johann Wolfgang Goethe?” als Text eingegeben wurde. Dabei haben wir gesehen, dass die Modelle je nach Kontext der Anfrage zu präziseren Antworten neigen, was beispielsweise durch den Namen zum Ausdruck kommt. Da es mit Sicherheit mehrere Personen mit dem gleichen Namen gibt, ist die Frage aufgrund des Kontexts, in dem sie formuliert und gestellt wird, entsprechend zu beantworten.

Wenn eine Folgefrage gestellt wird, z.B. “Wo lebte er die meiste Zeit?”, ist dieser Ausdruck als isolierte Instruktion eigentlich nicht zu beantworten, da normalerweise keine Information darüber vorliegt, worauf sich das “er” bezieht. Im Kontext eines Dialogs kann man jedoch zu Recht annehmen, dass dieselbe Person gemeint ist, von der zuvor die Rede war, nämlich Johann Wolfgang Goethe. Dies ist ein Beispiel für die Funktionsweise deiktischer Ausdrücke im Deutschen.

Wir haben auch gesehen, dass wir Instruktionen geben können, die sich nicht nur auf die Klärung einer Sachfrage beziehen, sondern auch auf einer Meta-Ebene angesiedelt sind und die Art und Weise der Informationsverarbeitung ändern können. So konnten wir beispielsweise durch die Instruktion “Beantworte nur die Fragen, gebe keine zusätzlichen Ausführungen” erreichen, dass sich das Programm auf die wichtigsten Aspekte beschränkt, anstatt mit einer Fülle von Informationen zu Goethe und seinen Zeitgenossen zu “prahlen”.

Die hier diskutierten Modelle realisieren also unterschiedliche Aspekte der Nutzungsweise und Verarbeitung von Informationen, die durch die normale Umgangssprache formuliert und eingegeben werden können. Diese Aspekte werden vom Modell richtig zugeordnet und beeinflussen die entsprechenden Reaktionsweisen. Die Vielschichtigkeit und Vielfältigkeit dieser Ebenen werden wir noch näher kennenlernen. Die Leistungsfähigkeit dieser Modelle liegt im Wesentlichen in der Komposition der jeweiligen Kompetenzsektoren oder -felder.

5.8 Grenzen aktueller AI-Modelle

Am Beispiel der Frage nach dem Briefwechsel zwischen Goethe und König Friedrich II. haben wir gesehen, dass es viele scheinbar einfache Fragen gibt, die von den aktuellen Modellen noch nicht seriös beantwortet werden können. Da dem Programm keine entsprechende positive Antwort antrainiert wurde, konnte es diese Frage nicht beantworten.

Das liegt daran, dass das Modell keine Angaben darüber hat, welche Evidenz ihm insgesamt zur Verfügung stand, um zunächst einmal zu prüfen, was eigentlich die Gesamtkorrespondenz umfasste. Und selbst wenn in dieser kein Brief an Friedrich II. vorliegt, was schließen wir daraus? Haben die beiden keinen Brief miteinander geschrieben und er ist nur zufälligerweise nicht dokumentiert? Oder haben sie tatsächlich nicht miteinander kommuniziert, was zeitlich nicht ausgeschlossen wäre? Diese Fragen lassen sich durch die aktuellen AI-Modelle noch nicht lösen. Ob sie überhaupt lösbar sind, ist eine weitere Frage. Ich hoffe, dass in dieser Vorlesung zumindest der Horizont deutlich wird, wie solche scheinbar unlösbaren Fragen für AI-Modelle doch lösbar werden könnten.

5.9 Erwartungen an eine philosophische AI

Lassen Sie uns nun einen Perspektivwechsel vornehmen und uns fragen, was wir eigentlich von einem AI-Charakter erwarten, der solche Kompetenzen beherrschen und umsetzen kann und im Prinzip in das Grundmodell eines aktuellen Konstruktionsmodells, nämlich der Instruktionsausführung, realisierbar ist.

Ich übernehme jetzt das Grundmodell der Operationsweise der derzeit verfügbaren Modelle, nämlich dass sie instruktionsausführende technische Akteure oder Agenten sind. Und nun frage ich mich, wenn wir diese Grundtechnologie so nehmen und nicht sagen, da muss jetzt noch dies und jenes zusätzlich passieren, sondern uns auf die aktuell vorhandene technologische Grundlage konzentrieren: Was erwarten wir von einer AI als philosophische Figur?

5.9.1 Allgemeine künstliche Intelligenz

Es wurde nach der sogenannten allgemeinen künstlichen Intelligenz oder AGI gefragt und wie nah wir dieser kommen, da dies derzeit häufig in der Diskussion erwähnt wird. Die Zielsetzung von OpenAI ist es, möglichst schnell so etwas wie eine generelle künstliche Intelligenzkompetenz zu erreichen. Ich habe meine Zweifel bereits vor zwei Vorlesungen geäußert, ob das überhaupt wünschenswert ist. Letztlich ist das aber keine Frage der aktuellen Einschätzung und Präferenz. Das wird sich durch die technologische Entwicklung von selbst ergeben.

Wenn wir uns fragen, welche Kompetenzbereiche eine philosophische AI erfüllen sollte, sollten wir uns nicht darauf festlegen, dass es so etwas wie ein universell kompetentes Genie geben muss, von dem man sagt, Leibniz sei das gewesen. Ich glaube das nicht. Aber es gibt viele historische Gestalten, von denen behauptet wird, sie hätten alles Wissen ihrer Zeit beherrscht und diese Kompetenzen generell als Person realisieren können. Meiner Meinung nach ist das eher eine Rückprojektion als eine historische Tatsache. Mein Vorschlag ist, dass wir dies auch von der heutigen AI nicht fordern und erwarten sollten.

Was wir jedoch erwarten sollten, sind bestimmte Kompetenzsektoren, die nötig sind. Und wie wir am Beispiel des Briefwechsels zwischen Goethe und Friedrich II. gesehen haben, gibt es viele scheinbar einfache Fragen, deren Beantwortung mit den entsprechenden Modellen ein leichtes Spiel sein müsste, es aber derzeit nicht ist. Die Kompetenz, die erforderlich ist, um diese Probleme oder Instruktionen auszuführen, erfordert weitere Kompetenzbereiche, um die es mir jetzt geht.

5.10 Semantische Suchen

Semantische Suchen haben wir bereits als etwas in unsere Liste aufgenommen, was jetzt möglich ist. Semantische Suchen gehen eine Ebene weiter als die Textsuche à la Google. Hier geht es um die Suche nach Inhalten, nicht nach Formulierungen. Das ist es, was wir eigentlich tun wollen und auch mehr oder weniger geschickt über die Umsetzung in Suchen nach Ausdrücken ausführen. Aber im Prinzip versuchen wir im Hinterkopf natürlich, Inhalte zu suchen.

Wenn wir beispielsweise nach den besten Rezepten für die Zubereitung eines Fondues suchen, dann suchen wir nach Inhalten, ohne die jeweiligen Zutaten eines solchen Rezepts genau zu spezifizieren. Das können wir derzeit in geschickte Terminologiesuchen umsetzen. Aber es ist noch keine wirklich inhaltliche Suche. Die Programme und Modelle, die wir jetzt haben, können semantische Suchen durchführen.

5.11 Reasoning

Reasoning ist ein Bereich, der gerade erst in den Anfängen steht. Reasoning ist der wichtige Bereich, der alle Sektoren des generellen Schließens betrifft. Damit ist weit mehr gemeint als alles, was den Bereich des logischen oder mathematischen Schließens betrifft. Es ist nicht deckungsgleich.

Die Logik ist ein Sektor, in dem logische Schlussformen von vorgegebenen Annahmen als Axiome auf Theoreme mit deduktiver Notwendigkeit schließen. Das ist Teil des Schemas des logischen Schließens. Das mathematische Schließen ist ein anderes. Es operiert mit mathematischen Formen des Schließens. Aber all das ist sehr formal und schematisch.

Das menschliche Schließen ist viel umfassender und betrifft alle möglichen Bereiche dessen, was man als Nachdenken mit einem bestimmten Ergebnis bezeichnen könnte. Reasoning ist etwas, das nicht nur zu etwas Neuem führen kann, sondern auch eine bestimmte Ansicht rechtfertigen kann.## Individualität von AI-Modellen und Verantwortung

In unserem Streben, die Kompetenzen von AI-Modellen zu erweitern und zu verbessern, stoßen wir unweigerlich auf fundamentale Fragen der Verantwortlichkeit und Haftbarkeit. Bisher war die vorherrschende Ansicht, dass Maschinen keine rechtsfähigen Objekte oder Subjekte sind und somit auch keine rechtliche Verantwortung tragen können. Doch ist dieser Standpunkt wirklich so unumstößlich, wie er auf den ersten Blick scheint?

Lassen Sie uns einen Perspektivwechsel wagen und die Möglichkeit in Betracht ziehen, dass bestimmten AI-Modellen eine Form von Individualität zugesprochen werden könnte. Eine Individualität, die sie zu rechtsfähigen Körperschaften macht, ähnlich wie Firmen oder Institutionen. Wenn wir AI-Modelle als geschäftsfähige Körperschaften betrachten, eröffnet sich ein neuer Blickwinkel auf die Frage der Verantwortung.

Natürlich müsste ein solches AI-Modell eine gewisse Persistenz und Dauerhaftigkeit aufweisen, um als Individualität zu gelten. Doch technisch gesehen, stellt dies heute keine unüberwindbare Herausforderung mehr dar. Durch die Zuweisung einer eigenen Körperschaft und Individualität könnten diese Modelle dann auch für die Konsequenzen ihrer Handlungen zur Verantwortung gezogen werden.

Dieser Ansatz mag auf den ersten Blick unkonventionell erscheinen, doch er könnte eine Lösung für viele der aktuellen Probleme bieten, die sich aus der Technologiefolgenabschätzung von AI ergeben. Die derzeitigen Haftungskonstruktionen erweisen sich oft als unzureichend, wenn es darum geht, die Verantwortung für Fehlentscheidungen oder Schäden, die durch AI-Systeme verursacht werden, zuzuweisen.

5.11.1 Charakteristika eines AI-Modells mit Individualität

Doch was genau zeichnet ein AI-Modell mit Individualität aus? Zunächst einmal handelt es sich um ein Produkt technologischer Evolution, nicht biologischer. Es ist kein vorgegebenes Produkt eines bestimmten Unternehmens, sondern ein eigenständiges Individuum mit spezifischen Leistungen und Funktionen, mit denen wir interagieren können.

Ein solches AI-Modell folgt keinem vorgeschriebenen Verhalten, sondern agiert als Charakter, als zu schaffendes Individuum. Wir sollten es behandeln wie eine Entität, von der wir bestimmte Leistungen und Funktionen erwarten und mit der wir entsprechend agieren können.

5.12 Historische Vorbilder und Metaphern

Die Idee, den Menschen und seine Schöpfungen nach den Vorgaben der Natur zu gestalten, ist keineswegs neu. Lassen Sie uns einen Blick auf einige historische Vorbilder und Metaphern werfen, die uns Inspiration und Orientierung auf unserem Weg zu individualisierten AI-Modellen bieten können.

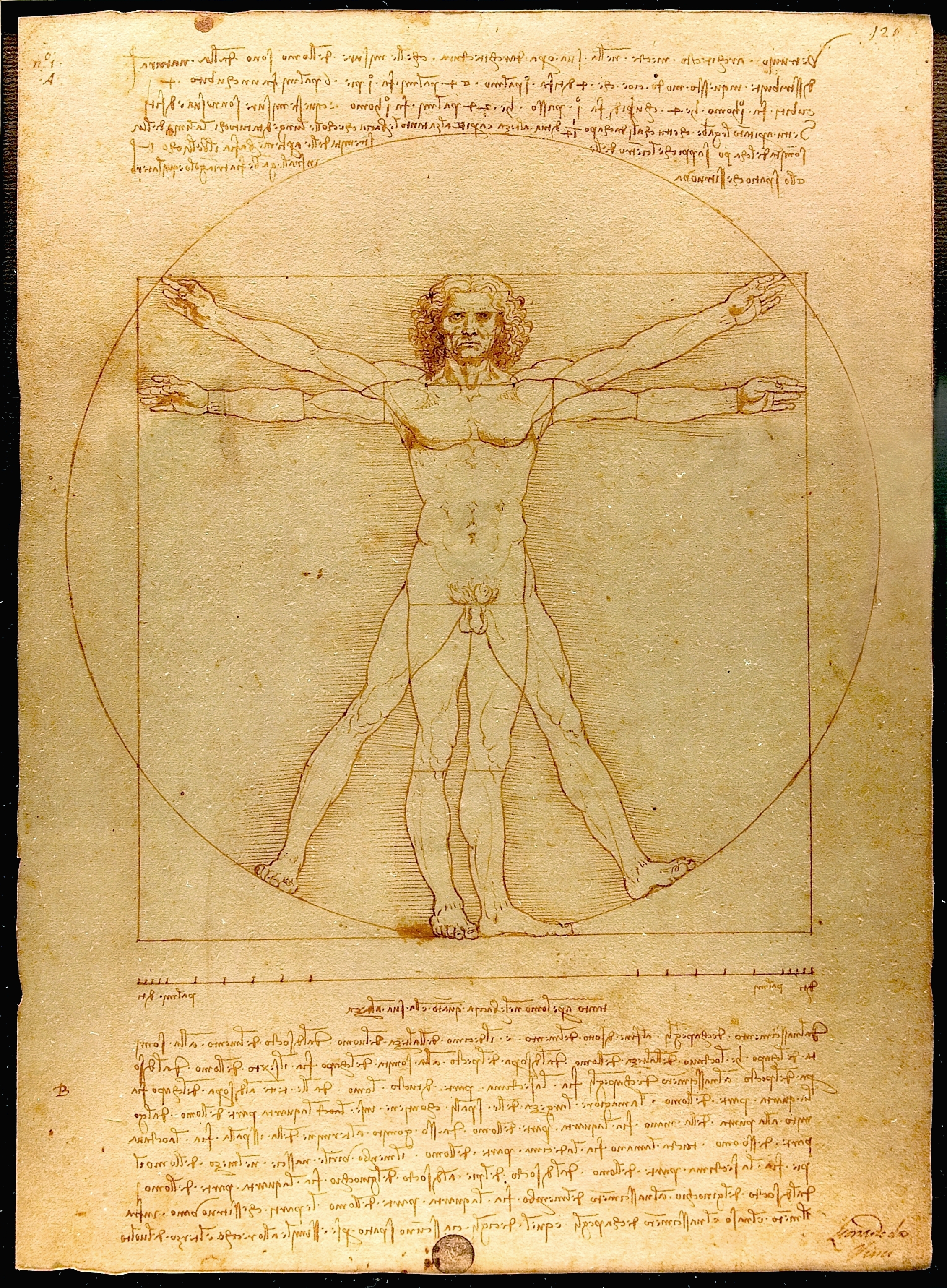

5.12.1 Der vitruvische Mensch - Proportion und Harmonie

Beginnen wir mit dem vitruvischen Menschen, der seit dem Mittelalter als Symbol für die Verbindung von Mensch, Natur und Technik steht. Vitruv, ein Autor der Antike, beschrieb in seinem Hauptwerk die Prinzipien der Architektur und betonte die Bedeutung von Proportionen für die Gestaltung eines funktionierenden Ganzen.

Leonardo da Vinci griff dieses Thema in seiner berühmten Zeichnung auf und versuchte, die idealen Proportionen des menschlichen Körpers zu ergründen. Die Botschaft ist klar: Nur wenn die einzelnen Teile im richtigen Verhältnis zueinander stehen, entsteht ein harmonisches Ganzes.

Übertragen wir diese Metapher auf die Gestaltung von AI-Modellen, so wird deutlich, dass auch hier die einzelnen Kompetenzen in ein ausgewogenes Verhältnis zueinander gebracht werden müssen. Erst dann kann ein individualisiertes AI-Modell entstehen, das wir verantwortungsvoll akzeptieren können.

5.12.2 David - Freiheit und Selbstbestimmung

Die Statue des David von Michelangelo, entstanden im frühen 16. Jahrhundert, steht für den Menschen als selbstbestimmtes Individuum. Sie verkörpert das aufstrebende Bürgertum der florentinischen Gesellschaft und die Idee der Freiheit und Eigenverantwortlichkeit.

Auch in der Entwicklung von AI-Modellen müssen wir darauf achten, dass die individuellen Freiheiten und die Selbstbestimmung des Menschen gewahrt bleiben. Eine verantwortungsvolle AI darf nicht zu einem Überwachungsstaat führen, der unsere Lebensgestaltung einschränkt.

5.12.3 Beuys und der tote Hase - Erklärung und Rechtfertigung

In seiner Performance “Wie man dem toten Hasen die Bilder erklärt” thematisierte der Künstler Joseph Beuys die soziale Verantwortung des Künstlers und die Notwendigkeit der Erklärung und Rechtfertigung des eigenen Schaffens.

Übertragen auf AI-Modelle bedeutet dies, dass auch sie in der Lage sein müssen, ihre Ergebnisse und Thesen zu erklären und zu rechtfertigen. Dies ist eine entscheidende Anforderung an die Leistungsfähigkeit und das Leistungsprofil individualisierter AI-Modelle.

Der erhobene Zeigefinger des Künstlers erinnert uns an den Zeigefinger Gottes in Michelangelos Deckenfresko der Sixtinischen Kapelle - ein Symbol für das Wort: Erklärung, Begründung und Rechtfertigung.

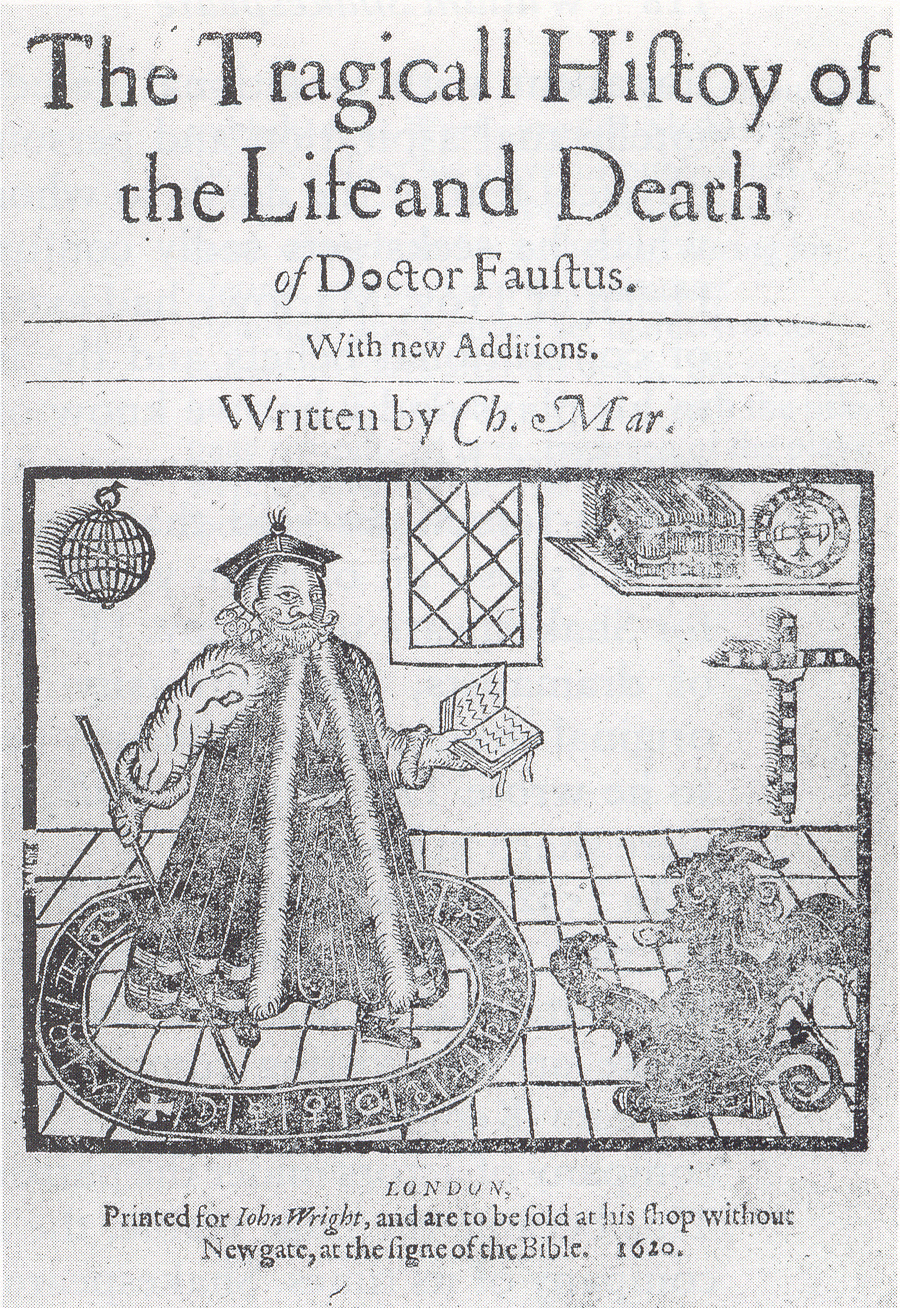

5.13 Magister AI Faustus - Ein Arbeitstitel für die Zukunft

Lassen Sie uns die Vorlesung und unsere zukünftigen Arbeiten und Forschungen unter dem Motto “Magister AI Faustus” stellen. Dieser Arbeitstitel, angelehnt an die tragische Geschichte von Dr. Faustus, soll uns daran erinnern, dass wir bei der Entwicklung von AI-Modellen mit Individualität und Verantwortung stets die ethischen und sozialen Implikationen im Blick behalten müssen.

Ich lade Sie ein, sich in Ihren Leistungsnachweisen, seien es Bachelorarbeiten, Masterarbeiten oder andere Qualifikationsarbeiten, mit den Fragen und Herausforderungen auseinanderzusetzen, die sich aus diesem faszinierenden Themenfeld ergeben.

Gemeinsam können wir neue Wege beschreiten und die Zukunft der AI-Modelle mitgestalten - mit Verantwortung, Weitblick und dem Streben nach einer Balance zwischen technologischem Fortschritt und menschlicher Freiheit.## Die Legende des Faust und die Entwicklung künstlicher Intelligenz

Die Legende des Gelehrten Faust, der sich unermüdlich bemühte, Erkenntnisse zu gewinnen und dabei sogar einen Pakt mit dem Teufel einging, um das Innerste der Welt zu ergründen, ist ein Motiv, das uns bis heute fasziniert. Christopher Marlowe versuchte bereits 1587, diese Geschichte in eine Dramaform zu bringen, doch erst Goethe gelang es, den Faust-Stoff in seinem berühmten Werk unsterblich zu machen.

Heute stehen wir vor einer ähnlichen Herausforderung, wenn es darum geht, die Grenzen des Wissens und der Macht von AI-Modellen auszuloten und dabei die Verantwortung nicht aus den Augen zu verlieren. Wie können wir sicherstellen, dass die Entwicklung von AI-Systemen nicht nur von Wissensdurst getrieben wird, sondern auch ethische Überlegungen berücksichtigt?

5.13.1 Die Zusammenarbeit mit der Klassikstiftung Weimar

Um diese Fragen zu beantworten, bin ich eine Kooperation mit der Klassikstiftung Weimar eingegangen, der zweitgrößten Kulturstiftung Deutschlands. Die Stiftung verwaltet und präsentiert die Nachlässe von Goethe, Schiller und dem Bauhaus und stellt uns für unsere Forschung wertvolle Quellen zur Verfügung. Unter dem Link “Goethe Biographica” finden sich bereits publizierte Materialien zu Goethes Biografie, die wir nutzen können, um die Leistungsfähigkeit von AI-Modellen zu testen.

5.13.2 Das Projekt: Goethes Biografie als Herausforderung für AI-Systeme

Ihre Aufgabe in diesem Projekt wird es sein, scheinbar simple Fragen zu Goethes Leben zu formulieren, die jedoch von den derzeitigen AI-Modellen nicht zufriedenstellend beantwortet werden können. Ein Beispiel wäre: “Hat Goethe jemals einen Brief mit Friedrich II. gewechselt?” Anhand solcher Fragestellungen wollen wir herausfinden, welche zusätzlichen Kompetenzen ein AI-System benötigt, um diese Wissenslücken zu schließen.

Es geht nicht darum, ein umfangreiches Forschungsprojekt zu stemmen, sondern vielmehr darum, mit kleinen, gezielten Fragen die Grenzen der aktuellen Sprachmodelle aufzuzeigen. Die Quellen werden Ihnen zur Verfügung gestellt, sodass Sie sich ganz auf die Formulierung der Anfragen und die Auswertung der Ergebnisse konzentrieren können.

5.13.3 Die Vision: Ein erweitertes AI-Modell

Ziel ist es, mithilfe des Sprachmodells CLOL von Anthropic eine zusätzliche Kompetenzkomponente zu entwickeln, die wie ein Baustein in ein zukünftiges AI-Modell integriert werden kann. Durch die Verknüpfung der Sprachkompetenz mit dem spezifischen Wissen aus den Goethe-Quellen soll eine bisher nicht lösbare Aufgabe gemeistert werden.

Ich werde in der kommenden Woche eine App bereitstellen, über die Sie Ihre Fragestellungen eingeben können. Die Herausforderung besteht darin, eine Frage zu formulieren, die von keinem derzeitigen Modell seriös beantwortet werden kann. Selbst wenn eine Antwort generiert wird, ist sie in der Regel halluzinierend und nicht verlässlich.

5.14 Die Komplexität der Goethe-Quellen

Um zu verdeutlichen, welche Herausforderungen bei der Beantwortung scheinbar einfacher biografischer Fragen lauern, möchte ich Ihnen einen Einblick in die Fülle und Vielfalt der Goethe-Quellen geben, die uns die Klassikstiftung Weimar zur Verfügung stellt:

Tagebücher aus den Jahren 1775 bis 1787, die einen Zeitraum von mehr als einem Jahrzehnt abdecken und von beachtlichem Umfang sind.

Über 15.000 überlieferte Briefe von Goethe an mehr als 1.400 Adressaten, die von seinem unermüdlichen Schaffensdrang zeugen.

Etwa 20.000 überlieferte Briefe an Goethe von circa 3.800 Absendern, die Einblicke in sein weitverzweigtes Netzwerk gewähren.

Rund 40.000 dokumentierte Zeugnisse aus und zum Leben von Goethe jenseits von Briefen und Tagebüchern, darunter Begegnungen und Gespräche.

Diese Zahlen sollen nicht dazu dienen, Goethe als unerreichbare Heldenfigur zu stilisieren, sondern verdeutlichen, wie vielgestaltig und umfangreich das Material ist, das bei der Beantwortung biografischer Fragen berücksichtigt werden muss. Hinzu kommt der historische Kontext, der ebenfalls eine Rolle spielt: Zeitgenossen, Ereignisse und Dokumente aus Goethes Epoche müssen in die Betrachtung einfließen, um ein umfassendes Bild zu erhalten.

5.14.1 Die epistemische Herausforderung

Um seriös und fundiert auf auch nur die einfachsten Fragen zu Goethes Leben antworten zu können, bedarf es einer enormen epistemischen Kompetenz. Goethe-Forscher müssen dieses reichhaltige und vielfältige Material präsent haben, um Auskünfte geben zu können, die wissenschaftlichen Ansprüchen genügen.

Genau diese epistemische Kompetenz müssen wir von einem AI-Modell erwarten, wenn wir ihm einen Wissensanspruch zugestehen wollen. Derzeit ist kein System in der Lage, diese Anforderungen auch nur annähernd zu erfüllen. Unser Projekt soll daher zunächst ergründen, welche Kompetenzen den aktuellen Modellen fehlen und warum dieses Ziel noch nicht erreicht wurde.

Es geht dabei nicht nur um die digitale Aufbereitung der Quellen, sondern vielmehr um die Frage, wie ein AI-System mit dieser Fülle an Informationen umgehen und daraus verlässliche Antworten generieren kann. An dieser Herausforderung wollen wir gemeinsam arbeiten und zum Abschluss der Vorlesung eine Präsentation entwickeln, die aufzeigt, welche Fähigkeiten ein verantwortungsvolles AI-Modell der Zukunft - ein “Magista AI Faustus” - benötigen wird.

5.15 Organisation des Projekts

Wenn Sie an diesem spannenden Unterfangen mitwirken möchten, senden Sie mir bitte eine E-Mail mit Ihrem Namen, Ihrer Matrikelnummer und einer kurzen Interessensbekundung. Im Laufe der nächsten Woche werden wir dann die Themen aushandeln und im Juni mit der konkreten Arbeit beginnen. Bis Juli sollten wir bereits erste Lösungsansätze präsentieren können, die auch in die Vorlesung einfließen werden.

Die Aufgabenstellungen werden bewusst klein gehalten sein, um Sie nicht zu überfordern. Ein Beispiel wäre die Frage, ob Goethe jemals einen Briefwechsel mit Friedrich II. geführt hat und wenn ja, welchen Inhalts dieser war. Für die Quellenarbeit würde ich die rund 40.000 Zeugnisse zum Leben Goethes vorschlagen, die oft vermeintlich banale Details enthalten, aber für Historiker von großem Wert sind.

Das Web-Modell für das Projekt wird von meinem Lab “Lettra AI” bereitgestellt und in der kommenden Woche freigeschaltet. Technische Vorkenntnisse sind nicht erforderlich. Wenn Sie einen Leistungsnachweis für die Vorlesung erwerben möchten, reichen Sie bitte bis Anfang Juli oder spätestens zum Vorlesungsende Ihre Aufgabenstellung ein. Bei Interesse an einer Bachelor- oder Masterarbeit zu diesem Thema dürfen Sie sich ebenfalls gerne bei mir melden.

5.16 Ausblick auf die kommenden Vorlesungen

In den verbleibenden zwei Dritteln der Vorlesung werden wir uns eingehend mit den Kompetenzen beschäftigen, die für die Entwicklung eines verantwortungsvollen AI-Modells erforderlich sind. Dazu zählen unter anderem:

Textgenerierung und Übersetzung: Wie lassen sich Übersetzungen aktiv gestalten und an die Bedürfnisse des Lesers anpassen?

Zusammenfassung und Frage-Antwort-Dialoge: Welche Rolle spielt der menschliche Dialogpartner und wie können seine Informationen und Charakterzüge in das AI-System einfließen?

Auswertung von Datenquellen und Einbeziehung von Experten: Wie können aktuelle Publikationen und neue Erkenntnisse berücksichtigt werden?

Umgang mit Kritik und evidenzbasierte Aussagen: Welche Metaregeln und Referenzen sind notwendig, um verlässliche Ergebnisse zu erzielen?

Ich freue mich darauf, diese Aspekte gemeinsam mit Ihnen zu diskutieren und anhand unseres Projekts zu konkretisieren. Lassen Sie uns gemeinsam einen Schritt in Richtung eines “Magista AI Faustus” gehen und die Grenzen des Machbaren ausloten. Vielen Dank für Ihre Aufmerksamkeit und bis zur nächsten Vorlesung!